İş Hayatında Büyük Veri – Dr. Usama Fayyad Open Insights

by 0

Bilkent Üniversitesi – TÜSİAD Bilgi Toplumu Forumu tarafından “İş Hayatında Büyük Veri” Konferansı’nda Open Insights Başkanı ve CEO’su Dr. Usama FAYYAD’ın ufuk açıcı konuşmasıyla büyük veriye farklı bir açıdan baktık.

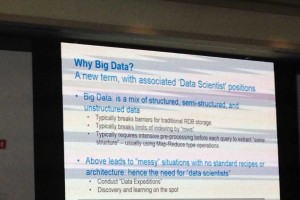

Büyük veri nedir?

Dr. Fayyad Büyük Veri’yi, daha kolay, hızlı ve düşük maliyetle sorunları gidermeyi vaat eden yeni nesil bir Veri Teknolojisi olarak açıkladı. Günümüzde iş hayatında beklentiler ve gerçekler birbirine uymuyor. Büyük veri aslında yapılandırılmış, yarı yapılandırılmış ve yapılandırılmamış verilerin bir karışımıdır. Verilerdeki karmaşıklık, veri bilim insanları tarafından yaratıcı çözümler ile düzenlenir. Bir veri bilim adamı, bir istatikçiden çok daha fazla yazılım mühendisliği bilen ve bir yazılım mühendisinden çok daha fazla istatistik bilen bir kişidir. Veri bilim insanı Silikon Vadisi’nde kritik, çok yüksek maaşlı ve nadirdir.

Büyük Veri’nin kritik faktörleri nelerdir?

Buna kritik Büyük 3V diyebiliriz. Bunlar, hacim (volume), hız (velocity) ve çeşitliliktir (variety). ‘’Büyük Veri’’ terimini duyduğumuzda aklımıza gelen ilk şey hacimdir. Hacim önemlidir fakat Büyük Veri sadece hacimle tanımlanamaz. Hız, veri geliş hızı gerçek zamanlı kısıtlamalara neden olur. Çeşitlilik önemli bir diğer faktördür çünkü aslında veriler çoğunlukla yapılandırılmamış veya yarı-yapılandırılmıştır ve yorumlanması için standart bir formül yoktur.

Büyük miktardaki verinin, formüle edilmediğinde ve anlamlandırılmadığında hiçbir değeri yoktur. Veri erişilebilir olmalıdır, tek bir tanımı olmalıdır, tanımlanmış amacına uygun olmalıdır, kaynağa dönüp izlenebilir olmalıdır. Ondan sonra bir anlamı olur ve değer oluşturur.

Veri Gölü (Data Lake), Hadoop nedir?

Veri gölü verileri bir sistem içerisinde, çeşitli şemalar ve yapısal şekillerde, genellikle biçim BLOB veya dosya olarak düzenlemeye olanak sağlayan bir metottur. Hadoop, Azure Depolama ve Amazon S3 platformu veri göl havuzu kurmak için kullanılabilir. https://en.wikipedia.org/wiki/Data_lake ) Verinin çeşitli ölçekleri ile, dünyadaki en karmaşık veri gölüne sahip olan kimdir? Bunun cevabı Amazon’dur.

Hadoop, dağıtılmış depolama ve bilgisayar kümelerinde bulunan, emtia yazılımı tarafından yapılmış çok geniş veri takımlarının dağıtık işlemleri için kullanılan açık kaynak kodlu yazılımdır. Hadoop içindeki tüm modüller, donanım arızaları yaygındır ve sistem tarafından kendiliğinden yönetilmelidir temel varsayımı ile tasarlanmıştır. ( https://en.wikipedia.org/wiki/Apache_Hadoop )

Peki öyleyse Hadoop kullanmalı mıyız?

Dr. Fayyad’ın cevabı şöyle ‘’Ayrıcalıklı depolama maliyeti terabyte başına 20$ k ile 50$ k arasında ve Hadoop ile bu 1$k’ya kadar düşüyor. Yeni veri yatayı Hadoop olarak tercih edilmelidir.”

GE’ye göre, veri göl sistemleri üç milyon uçuşun analizini yaptı – 340 tb veriye eşdeğer- 2000 kat daha hızlı ve analitik süreçlerden 10 kat daha ucuz.

Peki bugünkü gerçek sorunlar nelerdir?

- Veri yönetimi ve kontrol

- Nadir fakat kritik olan veri bilim insanlarının sayısı

- Veri ve matamatiksel analiz bilgi birikimi gerektiren bir uzmanlıktır ve uzman olmayan kişilere göre değildir.

Zamanın azaldığı gibi veri her geçen gün daha da fazlalaşıyor. Zor olan bu veriden hızlı bir şekilde değer elde etmektir. Günümüzde iş hayatında geri kalmak istemeyen farklı sektörlerden bir çok şirket dijital dönüşüme odaklanma eğilimdedir. Hatta kamu hizmetleri gibi geleneksel ve ‘’güvenli’’sektörlerden, dijital dönüşümün gerekliliği hakkında duyumlar alıyoruz. Bu konular hakkında daha çok konuşmaya devam edeceğimize inanıyorum.